Nel contesto di continua crescita dell’AI emerge una questione cruciale: “più grande è meglio”? Questa affermazione, che ha guidato gran parte dell’evoluzione recente, pone l’enfasi sulla creazione di modelli di machine learning di dimensioni sempre maggiori (LLM). Sebbene tale approccio abbia portato a notevoli successi, è importante analizzare criticamente la sua validità e sostenibilità, poiché sono emerse diverse limitazioni. Quale sarà il futuro dei LLM?

Indice degli argomenti:

Primo punto: più grande uguale più costoso

In primo luogo, l’addestramento di modelli di machine learning di grandi dimensioni è intensamente esoso in termini di risorse computazionali, rappresentando un problema non solo economico, ma anche ambientale, a causa dei massicci requisiti energetici. Inoltre, questi modelli giganti comportano un’insaziabile sete di dati, che pone problematiche non solo logistiche, ma anche etiche, riguardanti la raccolta e l’archiviazione di enormi quantità di informazioni.

Un altro aspetto da considerare è la questione dei rendimenti decrescenti. Non sempre un modello più grande comporta un miglioramento proporzionale delle prestazioni, in particolare quando la qualità dei dati utilizzati non è migliorata di pari passo. Questo può portare a problemi di generalizzazione, in cui i modelli si adattano eccessivamente ai dati di addestramento, mostrando scarse performance su dati inediti.

Inoltre, c’è la questione della trasparenza e dell’interpretabilità. La crescente complessità dei modelli li rende più difficili da comprendere e spiega l’incapacità di individuare e correggere facilmente i pregiudizi incorporati. Questo rappresenta un serio ostacolo alla responsabilità e alla fiducia nell’AI.

Infine, ma non meno importante, c’è la questione dell‘accessibilità. I costi e le esigenze di risorse dei modelli più grandi possono renderli inaccessibili per istituzioni, ricercatori o imprese più piccole, creando una potenziale disparità nell’accesso ai benefici dell’AI.

“Più grande è meglio” sta arrivando al termine

Ma forse la svolta più importante è la crescente consapevolezza che l’approccio “più grande è meglio” sta arrivando al termine della sua utilità. Se i modelli di AI devono continuare a migliorare, i loro creatori dovranno trovare il modo di ottenere più performance con meno risorse.

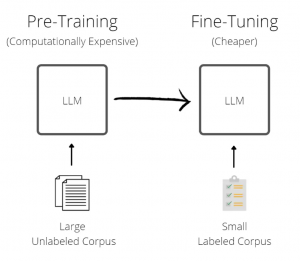

Il fine-tuning per compiti specifici, l’uso di tecniche di approssimazione matematica per ridurre i requisiti hardware, e l’adattamento di modelli generalisti in modelli più piccoli e specializzati sono soluzioni alternative. Si discute anche l’importanza del codice di programmazione e dell’hardware su cui viene eseguito, mettendo in luce le opportunità di miglioramento in questi settori.

Mentre il gigantismo dei LLM potrebbe aver raggiunto un punto di svolta, l’innovazione nel campo dell’AI è lontana dall’essere esaurita. Anzi, potrebbe essere all’inizio di una nuova era di sviluppo e scoperta.

Consideriamo una lezione storica: durante la Seconda Guerra Mondiale, le forze tedesche fecero uso di carri armati pesanti come il Tiger e il Panther, noti per la loro potenza e resistenza, ma che presentavano alti costi di produzione e problemi di manutenzione.

D’altra parte, le forze alleate, in particolare gli Stati Uniti, si concentrarono sulla produzione di carri armati più leggeri, come lo Sherman, che pur non essendo in grado di competere in termini di potenza di fuoco e corazzatura con i suoi omologhi tedeschi, poteva essere prodotto in grandi quantità, era più affidabile e più facile da riparare. Questa strategia si rivelò efficace nel contesto della guerra totale, dove l’efficienza produttiva e la sostenibilità logistica erano cruciali.

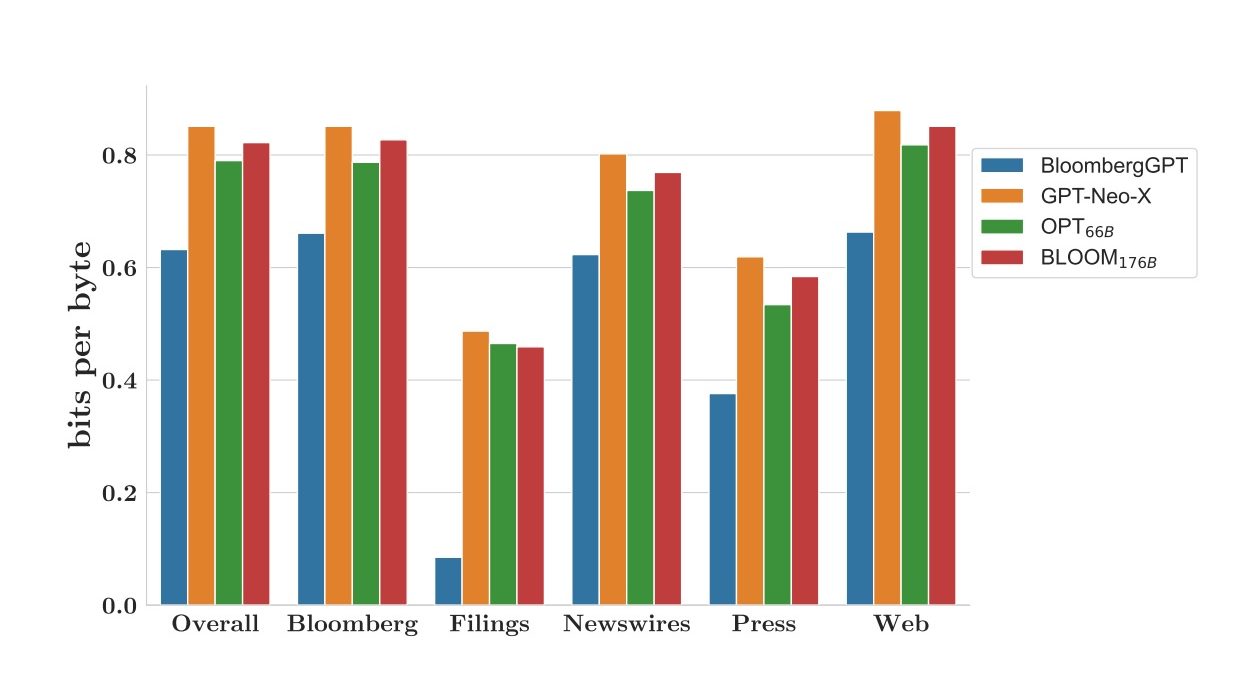

Oggi, nel contesto dell’intelligenza artificiale assistiamo a una tendenza simile. Mentre i giganti dei LLM come GPT-3 e GPT-4 hanno stabilito nuovi standard in termini di capacità, questi modelli richiedono enormi quantità di dati per l’addestramento, risorse di calcolo elevate e possono essere costosi da mantenere. La ricerca nell’ambito dell’IA si sta quindi spostando verso modelli più efficienti e specializzati come IndexGPT di JP Morgan e BloombergGPT di Bloomberg nel settore finanziario.

Il futuro dei LLM: una sfida dagli aspetti difficili

Parallelamente, il futuro dell’AI potrebbe vedere un mutamento nell’architettura dei LLM, analogamente a quanto è avvenuto nell’evoluzione dell’hardware dei computer. Piuttosto che puntare su processori singoli sempre più grandi, si è passati a soluzioni multiprocessore e multi-core. Allo stesso modo, l’industria dell’AI potrebbe passare da modelli sempre più grandi a “consorzi” di modelli più piccoli e specializzati.

Questi “consorzi” di modelli LLM potrebbero collaborare per gestire un’ampia gamma di compiti, garantendo allo stesso tempo una maggiore specializzazione e un adattamento più preciso ai contesti specifici. Si tratta di un cambiamento radicale rispetto all’attuale “one-size-fits-all” dei modelli giganti.

Naturalmente, ci saranno sfide da affrontare. La coordinazione e l’integrazione dei risultati di molti modelli diversi potrebbero richiedere nuovi approcci e tecniche.

Esistono diversi aspetti che contribuiscono a rendere questa sfida particolarmente ardua:

Compatibilità dei dati: ogni modello di apprendimento automatico ha bisogno di dati di addestramento per imparare. Tuttavia, differenti modelli possono necessitare di diversi tipi di dati. Ad esempio, un modello potrebbe richiedere dati di immagine, un altro testi, un altro ancora dati numerici. Inoltre, i dati di output di un modello potrebbero non essere compatibili con quelli richiesti da un altro modello come input. Di conseguenza, un’importante sfida sarà lo sviluppo di strumenti e standard che permettano la conversione e l’interpretazione dei dati in maniera efficiente e senza perdita di informazione.

Sincronizzazione: nell’architettura proposta, diversi modelli LLM lavoreranno in parallelo, ognuno con il proprio compito. Un problema critico sarà come coordinare il lavoro di questi modelli in modo che i risultati prodotti individualmente si combinino per raggiungere l’obiettivo finale. Inoltre, la sincronizzazione deve essere fatta in tempo reale per evitare ritardi che potrebbero influire negativamente sull’esperienza dell’utente.

Gestione degli errori: quando si lavora con una rete di modelli, un errore in uno di essi può avere effetti a cascata sugli altri. Per esempio, se un modello genera dati di output errati, i modelli che utilizzano questi dati come input possono produrre anch’essi risultati errati. È quindi necessario sviluppare strategie per rilevare e gestire gli errori, riducendo il più possibile le conseguenze negative.

Bias e fairness: un altro aspetto critico è la gestione del bias. Se i dati di addestramento sono pregiudiziosi, i modelli probabilmente replicheranno tali bias. In una rete di modelli interconnessi, il bias di un modello potrebbe influenzare gli altri modelli. Dovranno quindi essere adottate misure per identificare, mitigare ed eliminare il bias nei modelli di apprendimento automatico. Allo stesso modo, è fondamentale assicurarsi che i modelli siano equi e non portino a discriminazioni o danni per determinati gruppi di persone.

Privacy e sicurezza: un sistema composto da molti modelli LLM interconnessi deve affrontare sfide importanti in termini di privacy e sicurezza. Se i modelli condividono dati tra di loro, è necessario garantire che queste informazioni non vengano compromesse o utilizzate in modo inappropriato. Le soluzioni possono includere crittografia, anonimizzazione dei dati e tecniche di apprendimento federato.

Etica: l’uso di AI e LLM solleva numerose questioni etiche. Oltre alla privacy, queste includono trasparenza, responsabilità, equità, e il rischio della sovraccarica di automazione. Questi temi etici devono essere attentamente considerati durante lo sviluppo e l’implementazione dei modelli LLM.

Addestramento e ottimizzazione: addestrare un singolo modello LLM può già essere complesso e richiedere molte risorse. Quando si parla di addestrare una rete di modelli, la complessità aumenta. Sarà necessario sviluppare metodi che permettano di ottimizzare il processo di addestramento, sia in termini di tempo che di risorse.

Conclusioni

In conclusione, è importante ricordare che nella storia della tecnologia, il concetto di “più grande” non è sempre stato sinonimo di “meglio”. Mentre i progressi nelle architetture delle reti neurali e nell’hardware per l’apprendimento profondo hanno permesso la creazione di modelli di lingua sempre più grandi, non dobbiamo trascurare le potenziali sfide e le implicazioni che possono derivare dall’aumento della dimensione e della complessità.

Piuttosto che puntare a modelli di dimensioni sempre maggiori, potrebbe essere più fruttuoso esplorare modi per costruire reti di modelli più piccoli e specializzati che lavorano insieme. Questo non solo potrebbe portare a miglioramenti in termini di efficienza e maneggevolezza, ma potrebbe anche aprire nuove strade per la personalizzazione e la privacy, consentendo ai modelli LLM di vivere e apprendere direttamente sui dispositivi degli utenti, piuttosto che su server centralizzati.

Tuttavia, questo non significa che la strada verso i modelli più piccoli e interconnessi sia priva di ostacoli. Occorre affrontare sfide tecniche significative, tra cui la compatibilità dei dati, la sincronizzazione, la gestione degli errori, la privacy, la sicurezza e l’ottimizzazione. Inoltre, non dobbiamo mai perdere di vista le importanti questioni etiche, come il bias, la fairness, e la trasparenza.

Il futuro dei LLM, quindi, potrebbe non essere dominato da giganti monolitici, ma da una comunità interconnessa di specialisti. Ciò richiederà un cambiamento di paradigma nell’approccio all’AI: da un focus sulla grandezza e la complessità a un approccio più olistico che prenda in considerazione aspetti come l’efficienza, la privacy, l’etica e l’impatto sulla società. Ma se ci riusciremo si apriranno affascinanti percorsi per l’evoluzione dell’intelligenza artificiale e del suo ruolo nel mondo.