ChatGPT è un chatbot progettato per rispondere alle domande, un nuovo modello linguistico, ma può anche essere utilizzato per eseguire il debug del codice. Lo ha sviluppato OpenAI, la società che sta dietro AlphaFold e GPT-3.

La società, sostenuta da Microsoft, ha sviluppato un modello linguistico di grandi dimensioni progettato per interagire con gli utenti in ”modo colloquiale”.

OpenAI afferma che il formato di dialogo del modello consente a ChatGPT di rispondere a domande di follow-up, ammettere i propri errori, sfidare premesse errate e rifiutare richieste inappropriate.

ChatGPT (Chat Generative Pretrained Transformer) è un modello di pari livello di InstructGPT, rilasciato lo scorso gennaio e progettato per fornire una risposta dettagliata a un’istruzione in un prompt.

Indice degli argomenti:

Cosa si può chiedere a ChatGPT

Ci sono tantissime cose che possiamo chiedere, per avere risposte utili.

In sostanza possiamo usarlo sia per avere informazioni in modo diretto (più diretto rispetto a un motore di ricerca) sia per aiutarci a scrivere qualcosa.

Esempi di utilizzo:

- Richiesta di informazioni di base – ChatGPT può aiutarvi a ottenere informazioni di base su qualsiasi cosa. Ad esempio, potete usare ChatGPT per semplici ricette.

- Scrivere un saggio o un riassunto su qualsiasi argomento – Chat GPT può aiutare a scrivere un saggio su quasi tutti gli argomenti.

- Scrivere una canzone o poesia su qualsiasi argomento.

- Scrivere un’e-mail in uno stile definito.

- Scrivere una sceneggiatura cinematografica.

- Scrivere un codice.

- Eseguire il debug del codice.

- Chiedete consigli su qualsiasi cosa. Turismo, diete…

Consigli per l’uso di ChatGpt

- Meglio essere specifici. Come spiega Bloomberg, se chiediamo ChatGPT “Che cos’è il marxismo?”, per esempio, avremo risposta passabile, probabilmente non migliore di quella su Wikipedia o Google. Invece, rendete la domanda più specifica: “Quali sono stati gli sviluppi importanti del marxismo francese nella seconda metà del XIX secolo?”. ChatGPT farà molto meglio, ed è anche il tipo di domanda a cui è difficile rispondere con Google e Wikipedia.

- ChatGPT farà ancora meglio se gli farete domande una dopo l’altra, per approfondire o spiegare meglio punti specifici. Chiedetegli informazioni sugli specifici marxisti francesi che cita, su cosa facevano e su come si differenziavano dalle loro controparti tedesche.

- ChatGPT è particolarmente bravo nel “confronto e nella contrapposizione”. In sostanza, ChatGPT ha bisogno lo indirizziamo bene. Una domanda ben fatta gli dà più punti di riferimento fissi. Dovete impostare l’atmosfera, il tono e il livello intellettuale della vostra domanda, a seconda del tipo di risposta che desiderate.

- Un altro modo per affinare le capacità di ChatGPT è quello di chiedere risposte con la voce di una terza persona. Se chiediamo: “Quali sono i costi dell’inflazione?”, potreste ottenere risposte che non sono esattamente sbagliate, ma nemmeno tanto interessante. Più interessante: “Quali sono i costi dell’inflazione? Rispondete utilizzando le idee di Milton Friedman”.

Come funziona ChatGPT?

ChatGPT un tipo di intelligenza artificiale progettata per generare testi simili a quelli umani in base agli input ricevuti. Utilizza algoritmi di apprendimento automatico per elaborare l’input e generare risposte coerenti e appropriate in linguaggio naturale.

Il bot deriva da modelli di apprendimento automatico per l’elaborazione del linguaggio naturale noti come Large Language Model (LLM). Gli LLM analizzano enormi quantità di dati testuali e deducono le relazioni tra le parole all’interno del testo. Colgono insomma le correlazioni statistiche (pattern) tra una parola e l’altra. In questa maniera possono poi “scrivere” una risposta prevedendo una parola dopo l’altra.

Questi modelli sono cresciuti negli ultimi anni grazie ai progressi della potenza di calcolo. I LLM accrescono le loro capacità con l’aumentare delle dimensioni dei dataset di input e dello spazio dei parametri.

L’addestramento più elementare dei modelli linguistici prevede la previsione di una parola in una sequenza di parole. Più comunemente, è quanto viene definito come next-token-prediction e masked language-modeling.

I dati di addestramento del bot sono costituiti da una vasta quantità di testi provenienti da diverse fonti, tra cui libri, articoli e forum online. Questo permette al bot di comprendere il contesto e la struttura del linguaggio usato in diverse situazioni e di generare risposte adeguate all’input dato.

Utilizza una combinazione di tecniche, tra cui una rete neurale ricorrente (RNN) e un modello di trasformazione (transformer). La RNN elabora l’input che l’assistente riceve e lo utilizza per generare una sequenza di parole o token. Il modello di trasformazione prende il risultato della RNN e lo usa per generare il testo finale. Questa combinazione di tecniche permette al chatbot di generare risposte coerenti e appropriate in tempo reale.

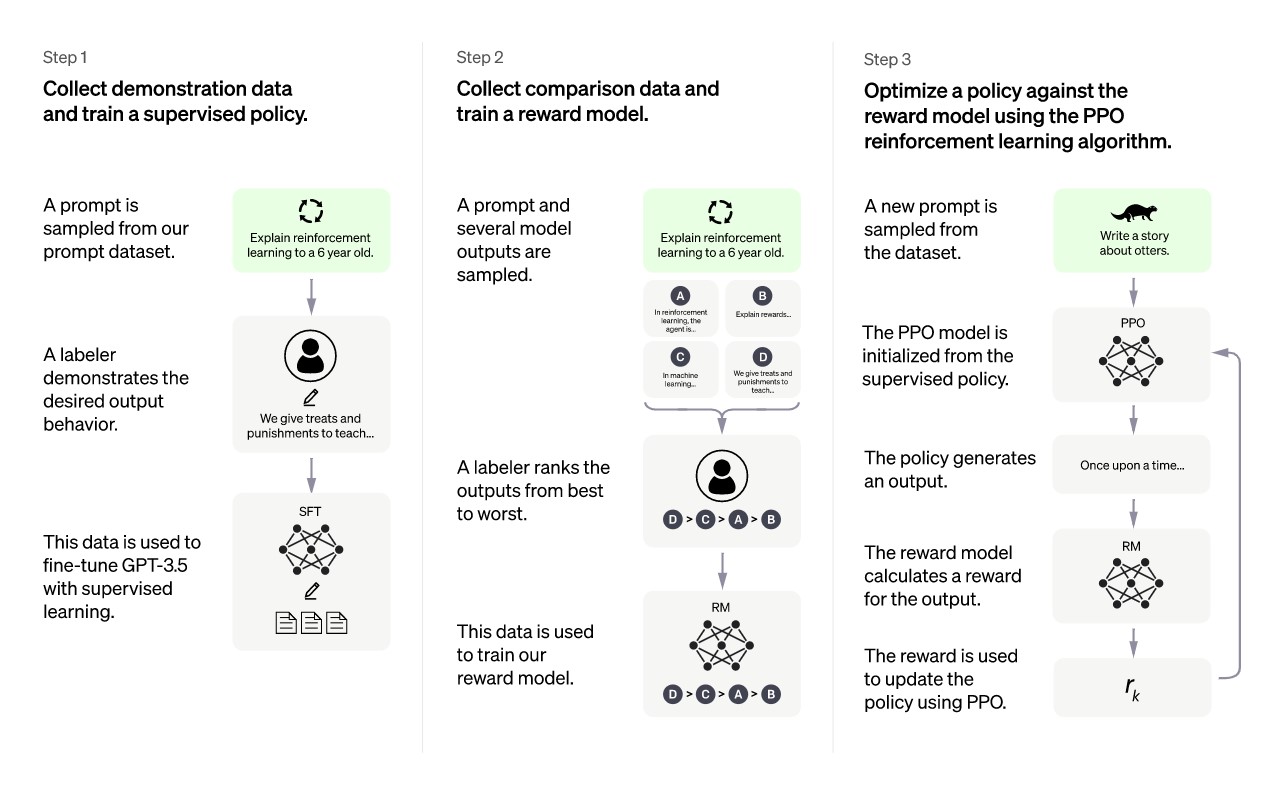

In particolare, ChatGPT è stato costruito utilizzando l’apprendimento per rinforzo dal feedback umano (RLHF). Il metodo è progettato per eliminare le risposte errate premiando le risposte corrette mentre corregge quelle che non lo sono.

Un modello iniziale è stato addestrato utilizzando la messa a punto supervisionata: i formatori di AI umani hanno fornito conversazioni in cui hanno giocato sia l’utente che un assistente AI. I formatori hanno avuto accesso a suggerimenti scritti su modelli per aiutarli a comporre le loro risposte.

GPT

Il modello stesso è stato costruito e messo a punto con GPT-3.5, una versione rivista del modello di punta di OpenAI che condivide il suo nome ma è costruito per essere migliore nella generazione di testo dettagliato. Sia ChatGPT che GPT 3.5 sono stati addestrati su un’infrastruttura di supercomputing di intelligenza artificiale di Azure, che Microsoft ha creato in collaborazione con OpenAI a maggio 2020.

”Per creare un modello di ricompensa per l’apprendimento per rinforzo, avevamo bisogno di raccogliere dati di confronto, che consistevano in due o più risposte modello classificate per qualità. Per raccogliere questi dati, abbiamo preso le conversazioni che i formatori di intelligenza artificiale hanno avuto con il chatbot. Abbiamo selezionato casualmente un messaggio scritto da un modello, campionato diversi completamenti alternativi e fatto classificare dai formatori di intelligenza artificiale. Utilizzando questi modelli di ricompensa, possiamo perfezionare il modello utilizzando l’ottimizzazione dei criteri prossimali. Abbiamo eseguito diverse iterazioni di questo processo”, afferma OpenAI sul proprio blog.

Limiti di ChatGPT

ChatGPT è effettivamente un chatbot e come altri è soggetto a generare output offensivo, come nel caso di BlenderBot 3 di Meta. OpenAI afferma di aver preso lezioni dai modelli precedenti, come GPT-3 e Codex, per cercare di migliorare l’affidabilità di ChatGPT, incluso l’utilizzo della sua tecnica di apprendimento per rinforzo per ottenere ”sostanziali riduzioni di output dannosi e non veritieri”. Ha applicato anche filtri etici per limitare hate speech e disinformazione.

Tuttavia, l’azienda di intelligenza artificiale riconosce che il suo modello ha dei limiti. Ad esempio, a volte scrive risposte plausibili ma errate o senza senso. Ha problemi anche nel fare calcoli. A volta ha quelle che gli esperti chiamano “allucinazioni”, confondendo realtà con fantasia. GPT coglie infatti, come detto, i rapporti statistici tra le parole; ma non ha contezza dei rapporti tra parole e il mondo. Non conosce né capisce insomma, davvero, ciò che scrive.

Può alimentare così la disinformazione, ad esempio in ambito medico o politico, come rilevato da molti esperti, nonostante i filtri presenti.

Il modello è anche prolisso, tende ad avere uno stile piatto e abusa di alcune frasi, come riaffermare che si tratta di un modello linguistico addestrato da OpenAI – che secondo la società deriva da pregiudizi nei dati di addestramento.

OpenAI afferma anche che l’AI potrebbe avere una conoscenza limitata degli eventi o delle conoscenze dopo il 2021, in base a quando il modello è stato addestrato.

”Abbiamo fatto molti sforzi per far sì che il modello rifiuti richieste inappropriate, ma a volte risponderà a istruzioni dannose o mostrerà comportamenti distorti”, ha detto OpenAI. ”Stiamo usando l’API di moderazione per avvisare o bloccare determinati tipi di contenuti non sicuri, ma ci aspettiamo ancora alcuni falsi negativi e positivi”.

Per affrontare i limiti del modello, OpenAI ha dichiarato di volersi impegnare a fare aggiornamenti regolari per migliorarlo e che lavorerà anche per fornire un’interfaccia accessibile.

Cosa ne pensano di Chat GPT gli esperti di AI

Come per ogni nuova versione di modello, la comunità AI ha reagito in modi molto diversi. Alcuni hanno chiesto a ChatGPT di generare prompt per generatori di testo-immagine, come MidJourney o Stable Diffusion, e li hanno utilizzati su questi modelli.

La prof.ssa Emily M. Bender, direttrice del Computational Linguistics Laboratory dell’Università di Washington, ha ricordato che ChatGPT: ”è ancora solo un modello linguistico: solo una macchina di sintesi testuale / generatore casuale di BS”.

Pochi giorni dopo il rilascio del modello, StackOverflow, il sito di domande e risposte dei programmatori, ha temporaneamente vietato agli utenti di pubblicare risposte generate da ChatGPT, dicendo che il volume di risposte errate ma plausibili era troppo grande.

Al WAICF 2023, l’evento annuale dedicato all’intelligenza artificiale che si tiene a Cannes, alcuni scienziati hanno criticato ChatGPT, ridimensionandone la portata e parlando addirittura di “illusione”.

A cosa serve ChatGPT in pratica

Strumenti come ChatGPT possono creare grandi opportunità per le aziende che sfruttano la tecnologia in modo strategico. L’intelligenza artificiale basata su chat può aumentare il modo in cui gli esseri umani lavorano automatizzando le attività ripetitive e fornendo interazioni più coinvolgenti con gli utenti.

Ecco alcuni dei modi in cui le aziende possono utilizzare strumenti come ChatGPT:

- Compilazione di ricerche

- Idee di brainstorming

- Scrittura di codice informatico

- Automatizzare parti del processo di vendita

- Fornire servizi post-assistenza quando i clienti acquistano prodotti

- Fornire istruzioni personalizzate

- Razionalizzazione e miglioramento dei processi utilizzando l’automazione

- Traduzione di testo da una lingua all’altra

- Facilitare il processo di onboarding dei clienti

- Aumentare il coinvolgimento dei clienti, con conseguente miglioramento della fidelizzazione e della fidelizzazione

Il servizio clienti è una grande area di opportunità per molte aziende. Le aziende possono utilizzare la tecnologia ChatGPT per generare risposte per i propri chatbot del customer care in modo da poter automatizzare molte attività tipicamente svolte dagli esseri umani e migliorare radicalmente i tempi di risposta.

Secondo un rapporto di Opus Research, il 35% dei consumatori vorrebbe che più aziende utilizzassero i chatbot e al 48% dei consumatori non importa se un essere umano o un chatbot automatizzato li aiuta con una query del servizio clienti. D’altra parte, le opportunità dei chatbot basati sull’intelligenza artificiale possono trasformarsi in minacce se i tuoi concorrenti sfruttano con successo questa tecnologia e la tua azienda no.

ChatGPT, i settori aziendali in cui potrebbe essere impiegato

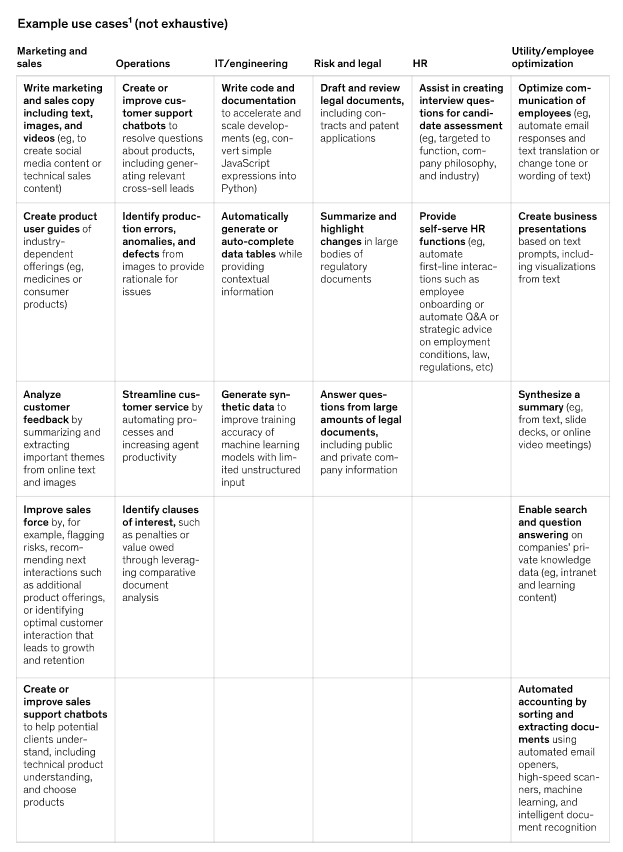

Secondo McKinsey & co., le funzioni in cui modelli come ChatGPT potrebbero essere usati sono:

- Marketing e vendite: creazione di contenuti di marketing, social media e di vendita tecnici personalizzati (inclusi testo, immagini e video); Creazione di assistenti allineati ad attività specifiche, come la vendita al dettaglio

- Operazioni: generazione di elenchi di attività per l’esecuzione efficiente di una determinata attività

- IT/ingegneria: scrittura, documentazione e revisione del codice

- Rischio e legale: rispondere a domande complesse, attingere da grandi quantità di documentazione legale e redigere e rivedere relazioni annuali

- R&S: accelerare la scoperta di farmaci attraverso una migliore comprensione delle malattie e la scoperta di strutture chimiche.

A questo possiamo aggiungere tra le altre cose:

- un uso ora fatto da Morgan Stanley: supporto alle decisioni manageriali usando l’analisi big data del proprio capitale informativo interno (documenti).

- sintesi di (video) call

Fonte: McKinsey

Un team interfunzionale per rispondere alle principali domande

Per McKinsey, nelle aziende che considerano l’AI generativa, i dirigenti vorranno identificare rapidamente le parti del loro business in cui la tecnologia potrebbe avere l’impatto più immediato e implementare un meccanismo per monitorarla, dato che si prevede che si evolverà rapidamente. Una mossa è quella di riunire un team interfunzionale, inclusi professionisti della Data science, esperti legali e leader aziendali funzionali, per riflettere su domande di base, come queste:

- In che modo la tecnologia potrebbe aiutare o interrompere il nostro settore e / o la catena del valore della nostra attività?

- Quali sono le nostre politiche e la nostra posizione? Ad esempio, stiamo aspettando attentamente di vedere come si evolve la tecnologia, investendo in progetti pilota o cercando di costruire un nuovo business? La postura dovrebbe variare tra le aree dell’azienda?

- Dati i limiti dei modelli, quali sono i nostri criteri per selezionare i casi d’uso da targetizzare?

- Come perseguiamo la costruzione di un ecosistema efficace di partner, comunità e piattaforme?

- A quali standard legali e comunitari dovrebbero aderire questi modelli in modo da poter mantenere la fiducia con i nostri stakeholder?

Nel frattempo, è essenziale incoraggiare un’innovazione ponderata in tutta l’organizzazione, posizionando guardrail insieme ad ambienti sandbox per la sperimentazione, molti dei quali sono prontamente disponibili tramite il cloud, con più probabilità all’orizzonte.

ChatGPT per i professionisti

Il modello di AI generativa di OpenAI offre una serie di opportunità per aumentare l’efficienza e la produttività. È possibile utilizzarlo per generare risposte automatiche per le e-mail, anche personalizzate. Come traduttore, aiuto nella scrittura di articoli, racconti, brevi narrazioni, aiuto nella scrittura di codice, debug e riconoscimento/ricerca di errori. Leggi come nella mini-guida ChatGPT per professionisti: come sfruttare al massimo la piattaforma di OpenAI.

ChatGPT, i potenziali pericoli

Ci sono enormi opportunità per le aziende di utilizzare strumenti come ChatGPT per migliorare i loro profitti e creare esperienze migliori per i clienti, ma ci sono anche alcuni potenziali pericoli con questa tecnologia. Nella versione beta del software ChatGPT, OpenAI riconosce gli attuali limiti dell’AI, incluso il potenziale di generare occasionalmente informazioni errate o contenuti distorti.

Ci sono anche potenziali problemi di privacy, per tutte le informazioni che ottiene dagli utenti.

ChatGPT può essere vulnerabile agli attacchi di sicurezza informatica, in quanto è connesso a Internet e potrebbe potenzialmente essere utilizzato per diffondere contenuti dannosi o virus. I criminali informatici malintenzionati potrebbero anche manipolare le persone affinché divulghino informazioni personali utilizzando il chatbot, quindi utilizzare tali informazioni per scopi fraudolenti o per attacchi di phishing mirati.

Infine, iniziano a manifestarsi i timori per un utilizzo diffuso di ChatGPT da parte delle aziende. In particolare, si teme che l’adozione di questo strumento possa portare al taglio di posti di lavoro. Secondo un sondaggio di Sortlist Data Hub effettuato in Regno Unito, Belgio, Germania, Spagna, Paesi Bassi e Francia, infatti, ChatGPT potrebbe provocare tagli nell’organico per il 26% delle aziende tecnologiche europee. A rischiare di più sono i lavoratori di marketing e public relation

Le limitazioni

Ai primi di gennaio 2023, l’International Conference on Machine Learning (ICML) ha impedito agli autori di presentare articoli contenenti testo generato da strumenti come ChatGPT. Inoltre, le scuole di New York City hanno vietato agli studenti di utilizzare ChatGPT per paura che possa essere usato per imbrogliare. Ora è vietato su tutti i dispositivi e le reti nelle scuole pubbliche.

Un portavoce di OpenAI ha dichiarato al Washington Post che sta sviluppando “mitigazioni per aiutare chiunque a identificare il testo generato da quel sistema”.

C’è poi il problema della legalità delle opere generate dall’AI; attualmente, solo un’opera ha ottenuto la protezione del copyright: un fumetto negli Stati Uniti, anche se l’Ufficio copyright Usa sta rivedendo la sua decisione.

Il gigante dei servizi finanziari JP Morgan Chase ha vietato al suo personale di utilizzare ChatGPT. Lo riferisce la CNN, citando fonti che affermano che la decisione, che si applica al personale globale, è dovuta a problemi di conformità sull’utilizzo di software di terze parti.

Come usare gratuitamente ChatGPT

Si può provare ChatGPT gratuitamente durante la fase di anteprima della ricerca. Per accedere al modello, si deve creare un account OpenAI e dichiarare di avere più di 18 anni.

Clicca qui per provare gratis ChatGTP

Video: Mini-corso per imparare a usare ChatGPT

ChatGPT a pagamento

E’ uscita già una versione a pagamento – per ora solo negli Usa – di ChatGPT, a 20 dollari, chiamata ChatGPT Plus. Per un uso senza attesa e senza limiti di caratteri.

ChatGPT e Bing di Microsoft

ChatGPT può essere utilizzato per rispondere in modo sintetico alle query di ricerca nel motore di ricerca Bing di Microsoft, invece di mostrare semplicemente i collegamenti. Questa nuova versione potrebbe essere lanciata entro la fine di marzo. Da febbraio è disponibile con accesso limitato (c’è una lista di attesa).

In questo modo, Microsoft sta cercando di guadagnare terreno nei confronti di Google Search. Secondo Statista, Google Search detiene una quota di mercato dell’84% rispetto al 9% per il secondo posto di Bing (a settembre 2022).

Microsoft ha incorporato la tecnologia di OpenAI anche in Edge, il suo browser web, come una sorta di assistente di scrittura superpotenziato. Gli utenti possono ora aprire un pannello in Edge, digitare un argomento generico e ottenere un paragrafo, un post sul blog, un’e-mail o un elenco di idee generati dall’IA e scritti in uno dei cinque toni disponibili (professionale, informale, informativo, entusiasta o divertente). Possono incollare il testo direttamente in un browser web, in un’applicazione di social media o in un client di posta elettronica.

Gli utenti possono anche chattare con l’IA integrata in Edge su qualsiasi sito web che stanno visualizzando, chiedendo riassunti o informazioni aggiuntive. In una dimostrazione impressionante di martedì, un dirigente Microsoft ha navigato sul sito web di Gap, ha aperto un file PDF con i risultati finanziari trimestrali più recenti dell’azienda e ha chiesto a Edge di riassumere i dati principali e di creare una tabella di confronto con i risultati finanziari più recenti di un’altra azienda di abbigliamento, Lululemon. L’IA ha fatto entrambe le cose, quasi istantaneamente.

L’integrazione di ChatGPT in futuro – come dichiarato dall’azienda – si estenderà a tutti i prodotti Microsoft Office, tra cui Word, PowerPoint e Outlook per consentire agli utenti di generare contenuti da prompt di testo.

Una prima integrazione è in Outlook, il suo servizio di posta elettronica, con uno strumento che aiuta i venditori a scrivere e-mail personalizzate.

La notizia si aggiunge a quella secondo cui Microsoft sarebbe in trattative per investire 10 miliardi di dollari in OpenAI. Microsoft ha già versato 1 miliardo di dollari nella società nel 2019 e detiene anche una licenza esclusiva per GPT-3.

In precedenza, Microsoft ha integrato un sistema OpenAI in uno dei suoi prodotti: DALL-E, lo strumento text-to-image utilizzato come base per Microsoft Designer, una piattaforma di progettazione grafica text-to-image AI destinata a rivaleggiare con Canva.

Anche CoPilot, basato su GPT-3, è uno strumento Microsoft e serve per assistere nella programmazione.

Bing e Edge con ChatGPT anche sui dispositivi mobili

Microsoft ha esteso i suoi prodotti potenziati dall’AI anche agli smartphone iOS e Android. Inoltre, ha lanciato Bing per Skype e ha allungato il tempo delle chat: fino a 6 per sessione, per un massimo di 60 chat totali al giorno, con l’obiettivo di arrivare presto a 100

La risposta di Google

Google intende rispondere con Bard, ma non ha fornito date. Ha specificato che integrerà questa AI nella search in modo diverso rispetto a Bing.

Google ha investito circa 300 milioni di dollari nella startup AI Anthropic, fondata da ex ingegneri OpenAI che hanno lavorato su GPT-3. Google ha acquisito una partecipazione del 10% nella startup; insieme svilupperanno sistemi di calcolo AI. L’investimento va nella direzione di aumentare i tentativi di Google di sviluppare le sue capacità di intelligenza artificiale generativa nel tentativo di contrastare la concorrenza di Microsoft.

Abusi dei modelli linguistici per le campagne di disinformazione: come ridurre il rischio

I ricercatori di OpenAI hanno collaborato con il Center for Security and Emerging Technology della Georgetown University e lo Stanford Internet Observatory per studiare come i modelli linguistici di grandi dimensioni potrebbero essere utilizzati in modo improprio per scopi di disinformazione. La collaborazione ha incluso un workshop dell’ottobre 2021 che ha riunito 30 ricercatori di disinformazione, esperti di apprendimento automatico e analisti politici ed è culminata in un rapporto co-autore basato su oltre un anno di ricerca. Questo rapporto delinea le minacce che i modelli linguistici rappresentano per l’ambiente informativo se utilizzati per aumentare le campagne di disinformazione e introduce un quadro per l’analisi di potenziali mitigazioni. Leggi il rapporto completo qui.

ChatGPT 4 e GPT4

A marzo OpenAi ha pubblicato GPT 4 (la quarta versione di GPT) e di conseguenza ChatGPT 4, oltre a fornire le Api di GPT4 per altri servizi e altre aziende. Bing ha integrato già la quarta versione.

ChatGPT 4 può essere usato per ora solo dagli utenti Open Ai a pagamento.

ChatGPT4 è un aggiornamento significativo rispetto alla versione precedente del modello. In particolare, è stato trainato su un set di dati molto più grande e diversificato. Ciò significa che il modello è in grado di comprendere una gamma più ampia di domande e risposte rispetto alla versione precedente. Inoltre, ci sono stati due grandi cambiamenti nell’approccio di sviluppo della nuova versione. In primo luogo, invece di utilizzare un modello di lingua pre-addestrato, i ricercatori hanno deciso di utilizzare un modello di apprendimento per rinforzo. Ciò significa che ChatGPT4 è stato in grado di apprendere in modo più efficiente dall’interazione con gli utenti. In secondo luogo, i ricercatori hanno utilizzato una tecnica di generazione di risposte più avanzata chiamata “sequential fine-tuning” che ha permesso al modello di generare risposte più coerenti e naturali.

“Abbiamo impiegato 6 mesi per rendere il GPT-4 più sicuro e allineato. Nelle nostre valutazioni interne, il GPT-4 ha l’82% in meno di probabilità di rispondere a richieste di contenuti non ammessi e il 40% in più di probabilità di produrre risposte fattuali rispetto al GPT-3.5”, scrive Open AI.

Una delle maggiori migliorie di GPT-4 è la sua capacità di generare testi più precisi e di qualità superiore rispetto a GPT-3. GPT-4 è stato addestrato su un vasto database di testi, consentendogli di comprendere e interpretare meglio le complessità del linguaggio umano. Inoltre, GPT-4 può anche generare testo che è più coerente e fluente, rendendolo una scelta migliore per le imprese che cercano di generare testi professionali, come descrizioni di prodotti, contenuti web e pubblicità.

GPT-4 offre inoltre la possibilità di generare testi più lunghi, fare sintesi ed estrapolare informazioni da lunghi rapporti e documenti e di utilizzare immagini. Quest’ultimo punto è fondamentale per le aziende che cercano di creare contenuti visuali di alta qualità e non solo per descrivere il loro prodotto, ma anche per visualizzarlo. Ad esempio, un’azienda che vende abbigliamento può utilizzare GPT-4 per generare testi che descrivono sia le caratteristiche dei prodotti che le immagini dei vestiti indossati da modelli, offrendo una migliore esperienza di acquisto per i clienti.

Un miliardo di visualizzazioni di pagina

Il 14 marzo 2023, OpenAI annuncia che ChatGPT ha raggiunto un miliardo di visualizzazioni di pagina.

Come si addestra un’intelligenza artificiale large language model: approfondimento

Fase 1: obiettivi

Ogni sistema di intelligenza artificiale ha bisogno di un obiettivo. I ricercatori lo chiamano funzione obiettivo. Può essere semplice – ad esempio, “vincere il maggior numero possibile di partite a scacchi” – o complicata, come “prevedere le forme tridimensionali delle proteine, utilizzando solo le loro sequenze di amminoacidi”.

La maggior parte dei modelli linguistici di grandi dimensioni ha la stessa funzione obiettivo di base: Data una sequenza di testo, indovinare cosa viene dopo. Più avanti daremo a MailBot obiettivi più specifici, ma per ora atteniamoci a questo.

Fase 2: raccogliere molti dati

Successivamente, dobbiamo raccogliere i dati di addestramento che insegneranno a MailBot come scrivere. L’ideale è mettere insieme un archivio di testo di dimensioni colossali, che di solito significa miliardi di pagine raschiate da Internet, come post di blog, tweet, articoli di Wikipedia e notizie.

Per iniziare, utilizzeremo alcune librerie di dati gratuite e disponibili pubblicamente, come l’archivio di dati web Common Crawl. Ma vorremo anche aggiungere la nostra salsa segreta, sotto forma di dati proprietari o specializzati. Forse daremo in licenza alcuni testi in lingua straniera, in modo che MailBot impari a comporre e-mail in francese o spagnolo, oltre che in inglese. In generale, più dati abbiamo e più diverse sono le fonti, migliore sarà il nostro modello.

Prima di poter inserire i dati nel nostro modello, dobbiamo suddividerli in unità chiamate token, che possono essere parole, frasi o anche singoli caratteri. La trasformazione del testo in pezzi di dimensioni ridotte aiuta il modello ad analizzarlo più facilmente.

Fase 3: costruire la rete neurale

Una volta che i dati sono stati tokenizzati, dobbiamo assemblare il “cervello” dell’I.A., un tipo di sistema noto come rete neurale. Si tratta di una complessa rete di nodi (o “neuroni”) interconnessi che elaborano e memorizzano informazioni.

Utilizziamo qui un tipo di rete neurale relativamente nuovo, noto come modello trasformatore. Questi modelli sono in grado di analizzare più parti di testo contemporaneamente, rendendoli più veloci ed efficienti. (I modelli trasformatori sono la chiave di sistemi come ChatGPT, il cui acronimo completo sta per “Generative Pretrained Transformer”).

Fase 4: addestramento della rete neurale

Successivamente, il modello analizzerà i dati, token per token, identificando schemi e relazioni. Potrebbe notare che “Caro” è spesso seguito da un nome o che “Cordiali saluti” precede di solito il vostro nome. Identificando questi schemi, l’IA impara a costruire messaggi che abbiano un senso.

Il sistema sviluppa anche un senso del contesto. Ad esempio, potrebbe imparare che “banca” può riferirsi a un istituto finanziario o alla riva di un fiume, a seconda delle parole circostanti.

Man mano che apprende questi schemi, il modello di trasformazione disegna una mappa: una rappresentazione matematica enormemente complessa del linguaggio umano. Tiene traccia di queste relazioni utilizzando valori numerici noti come parametri. Molti dei migliori L.L.M. di oggi hanno centinaia di miliardi di parametri o più.

L’addestramento potrebbe richiedere giorni o addirittura settimane e un’immensa quantità di potenza di calcolo. Ma una volta terminato, sarà quasi pronto per iniziare a scrivere le vostre e-mail.

Stranamente, potrebbe sviluppare anche altre abilità. Quando le L.L.M. imparano a prevedere la parola successiva in una sequenza, più e più volte, possono acquisire altre abilità inaspettate, come ad esempio saper scrivere un codice. I ricercatori di Intelligenza Artificiale chiamano questi comportamenti emergenti, e a volte ne sono ancora confusi.

Fase 5: perfezionare il modello con l’aiuto di persone

Una volta addestrato un modello linguistico di grandi dimensioni, è necessario calibrarlo per un lavoro specifico. Un chatbot utilizzato da un ospedale potrebbe avere bisogno di capire i termini medici, ad esempio.

Per mettere a punto il bot, potremmo chiedergli di generare una serie di e-mail, assumere persone che le valutino in base all’accuratezza e poi inserire le valutazioni nel modello finché non migliora.

Si tratta di un’approssimazione dell’approccio utilizzato con ChatGPT, noto come apprendimento per rinforzo con feedback umano.

Come si è arrivati a ChatGpt: la storia tecnologica

Il successo di OpenAI non è arrivato dal nulla. Il chatbot è l’iterazione più raffinata di una serie di modelli linguistici di grandi dimensioni che risalgono ad anni fa. Ecco come siamo arrivati a questo punto.

Anni ’80-’90: Reti neurali ricorrenti

ChatGPT è una versione di GPT-3, un modello linguistico di grandi dimensioni sviluppato da OpenAI. I modelli linguistici sono un tipo di rete neurale che è stata addestrata su moltissimi testi. (Le reti neurali sono software ispirati al modo in cui i neuroni nel cervello degli animali si segnalano a vicenda). Poiché il testo è composto da sequenze di lettere e parole di lunghezza variabile, i modelli linguistici richiedono un tipo di rete neurale in grado di dare un senso a questo tipo di dati. Le reti neurali ricorrenti, inventate negli anni ’80, possono gestire sequenze di parole, ma sono lente da addestrare e possono dimenticare le parole precedenti in una sequenza.

Nel 1997, gli informatici Sepp Hochreiter e Jürgen Schmidhuber hanno risolto questo problema inventando le reti LTSM (Long Short-Term Memory), reti neurali ricorrenti con componenti speciali che consentono di conservare più a lungo i dati passati di una sequenza di input. Le LTSM potevano gestire stringhe di testo lunghe diverse centinaia di parole, ma le loro capacità linguistiche erano limitate.

2017: Trasformatori

La svolta che ha portato all’attuale generazione di modelli linguistici di grandi dimensioni è arrivata quando un team di ricercatori di Google ha inventato i trasformatori, un tipo di rete neurale in grado di tracciare la posizione di ogni parola o frase in una sequenza. Il significato di una parola dipende spesso dal significato di altre parole che la precedono o la seguono. Tenendo traccia di queste informazioni contestuali, i trasformatori possono gestire stringhe di testo più lunghe e catturare il significato delle parole con maggiore precisione. Ad esempio, “hot dog” ha un significato molto diverso nelle frasi “Agli hot dog va data molta acqua” e “Gli hot dog vanno mangiati con la senape”.

2018-2019: GPT e GPT-2

I primi due grandi modelli linguistici di OpenAI sono arrivati a pochi mesi di distanza l’uno dall’altro. L’azienda vuole sviluppare un’intelligenza artificiale polivalente e generica e ritiene che i modelli linguistici di grandi dimensioni siano un passo fondamentale verso questo obiettivo. GPT (acronimo di Generative Pre-trained Transformer) ha fatto scuola, battendo i benchmark più avanzati dell’epoca per l’elaborazione del linguaggio naturale.

GPT combinava i trasformatori con l’apprendimento non supervisionato, un modo per addestrare i modelli di apprendimento automatico su dati (in questo caso, moltissimi testi) che non sono stati annotati in precedenza. In questo modo il software è in grado di individuare da solo gli schemi nei dati, senza che gli venga detto cosa sta guardando. Molti successi precedenti nel campo dell’apprendimento automatico si sono basati sull’apprendimento supervisionato e su dati annotati, ma l’etichettatura manuale dei dati è un lavoro lento che limita le dimensioni dei set di dati disponibili per l’addestramento.

Ma è stato il GPT-2 a creare il maggior scalpore. OpenAI ha dichiarato di essere così preoccupata che le persone possano usare GPT-2 “per generare un linguaggio ingannevole, distorto o abusivo” che non avrebbe rilasciato il modello completo. Come cambiano i tempi.

2020: GPT-3

Il GPT-2 era notevole, ma il seguito di OpenAI, il GPT-3, colpito davvero la comunità scientifica.

La sua capacità di generare testi simili a quelli umani ha rappresentato un grande balzo in avanti. GPT-3 può rispondere a domande, riassumere documenti, generare storie in diversi stili, tradurre tra inglese, francese, spagnolo e giapponese e molto altro ancora. Il suo mimetismo è sorprendente.

Uno dei risultati più notevoli è che i guadagni di GPT-3 sono stati ottenuti grazie al sovradimensionamento di tecniche esistenti piuttosto che all’invenzione di nuove. GPT-3 ha 175 miliardi di parametri (i valori di una rete che vengono regolati durante l’addestramento), rispetto agli 1,5 miliardi di GPT-2. Inoltre, è stato addestrato su un numero molto maggiore di reti. Inoltre, è stato addestrato su un numero molto maggiore di dati.

Ma l’addestramento su testi presi da Internet comporta nuovi problemi. GPT-3 ha assorbito gran parte della disinformazione e dei pregiudizi che ha trovato online e li ha riprodotti su richiesta. Come ha riconosciuto OpenAI: “I modelli addestrati su Internet hanno pregiudizi su scala Internet”.

Dicembre 2020: Testo tossico e altri problemi

Mentre OpenAI era alle prese con i pregiudizi di GPT-3, il resto del mondo tecnologico stava affrontando una resa dei conti di alto profilo sull’incapacità di contenere le tendenze tossiche dell’IA. Non è un segreto che i modelli linguistici di grandi dimensioni possano emettere testi falsi o addirittura odiosi, ma i ricercatori hanno scoperto che la risoluzione del problema non è sulla lista delle cose da fare per la maggior parte delle aziende Big Tech. Quando Timnit Gebru, co-direttore del team di etica dell’IA di Google, è stato coautore di un documento che evidenziava i potenziali danni associati ai modelli linguistici di grandi dimensioni (tra cui gli elevati costi di calcolo), non è stato accolto con favore dai dirigenti dell’azienda. Nel dicembre 2020, Gebru è stata allontanata dal suo posto di lavoro.

Gennaio 2022: InstructGPT

OpenAI ha cercato di ridurre la quantità di disinformazione e di testo offensivo prodotto da GPT-3 utilizzando l’apprendimento per rinforzo per addestrare una versione del modello sulle preferenze dei tester umani. Il risultato, InstructGPT, è stato migliore nel seguire le istruzioni delle persone che lo utilizzano – noto come “allineamento” nel gergo dell’intelligenza artificiale – e ha prodotto meno linguaggio offensivo, meno disinformazione e meno errori in generale. In breve, InstructGPT è meno tossico, a meno che non gli venga chiesto di esserlo.

Maggio-luglio 2022: OPT, BLOOM

Una critica comune ai modelli linguistici di grandi dimensioni è che il costo del loro addestramento rende difficile per tutti i laboratori, tranne quelli più ricchi, costruirne uno. Ciò solleva il timore che un’intelligenza artificiale così potente venga costruita da piccoli team aziendali a porte chiuse, senza un adeguato controllo e senza il contributo di una comunità di ricerca più ampia. In risposta, una manciata di progetti collaborativi ha sviluppato modelli linguistici di grandi dimensioni e li ha rilasciati gratuitamente a tutti i ricercatori che vogliono studiare e migliorare la tecnologia. Meta ha costruito e regalato OPT, una ricostruzione di GPT-3. Hugging Face ha guidato un consorzio di circa 1.000 ricercatori volontari per costruire e rilasciare BLOOM.

Dicembre 2022: ChatGPT

Persino OpenAI è sbalordita dal modo in cui ChatGPT è stato accolto. Nella prima dimostrazione che l’azienda mi ha fornito il giorno prima del lancio online, ChatGPT è stato presentato come un aggiornamento incrementale di InstructGPT. Come quel modello, ChatGPT è stato addestrato usando l’apprendimento per rinforzo sul feedback di tester umani che hanno valutato le sue prestazioni come interlocutore fluido, accurato e inoffensivo. In effetti, OpenAI ha addestrato GPT-3 a padroneggiare il gioco della conversazione e ha invitato tutti a giocare. Da allora, milioni di persone stanno giocando.

ChatGPT e Cina

Il governo di Pechino fornirà supporto finanziario alle aziende cinesi che sviluppano le proprie versioni di ChatGPT. Baidu, Alibaba, NetEase e JD.com sono tra i primi a mostrare interesse nello sviluppo di strumenti di intelligenza artificiale generativa. Intanto, OpenAI ha vietato agli utenti cinesi di accedere a ChatGPT.

ChatGPT allarma il mondo del lavoro

Dicembre 2020: lo staff dell’American Writers and Artists Institute, organizzazione che riunisce i copywriter, si rende conto della portata di ChatGPT, delle sue capacità, che rientrano perfettamente nella sfera di competenza di coloro che generano contenuti, come testi pubblicitari e post di blog, e lo fanno per vivere. Secondo un sondaggio condotto dal sito web di ricerca di lavoro ZipRecruiter, il 62% delle persone in cerca di lavoro si è detto preoccupato che l’intelligenza artificiale possa ostacolare le loro carriere.

Anche OpenAI ammette, dopo aver condotto una ricerca, che ChatGPT può mettere a rischio posti di lavoro. In particolare, rivela che l’80% della forza lavoro statunitense potrebbe vedere almeno il 10% delle proprie attività lavorative influenzate da GPT. Per la sua ricerca OpenAI utilizza il suo ultimo modello linguistico di apprendimento automatico (LLM), GPT-4, nonché l’esperienza umana. Ecco quali sono i lavori più a rischio.

23 marzo 2023 – Per ChatGPT arrivano i plugin…

…e i rischi per la cybersecurity

Alla stessa data, la divisione threat intelligence di Check Point Software Technologies Ltd., fornitore di soluzioni di cybersecurity a livello globale, rende pubblica una prima analisi facendo emergere cinque scenari che potrebbero consentire ai criminali informatici di sfruttare il tool di OpenAI in modo più rapido e preciso. CPR avverte sul potenziale di ChatGPT 4 nell’accelerazione dell’esecuzione di crimini informatici.

31 marzo 2023 – Il Garante della privacy dà lo stop a ChatGPT: raccolta illecita di dati personali

L’Autorità contesta a OpenAI l’assenza di una base giuridica che giustifichi la raccolta e la conservazione massiccia di dati personali, allo scopo di “addestrare” gli algoritmi e di sistemi per la verifica dell’età dei minori. Il 20 marzo il chatbot aveva subito una perdita di dati riguardanti le conversazioni degli utenti e le informazioni relative al pagamento degli abbonati al servizio a pagamento.

11 aprile 2023 – Il Garante della privacy detta a OpenAI le condizioni per la rimozione del blocco italiano

L’Autorità ha dato tempo alla società fino al 30 aprile per mettersi in regola. La limitazione provvisoria sarà sospesa se OpenAI adotterà le misure richieste: rendere disponibile sul proprio sito un’informativa trasparente, in cui siano illustrate modalità e logica alla base del trattamento dei dati necessari al funzionamento di ChatGPT nonché i diritti attribuiti agli utenti e agli interessati non utenti e un age gate che escluda, sulla base dell’età dichiarata, gli utenti minorenni.

Preoccupazioni per la privacy non soltanto in Italia

ChatGPT: i Garanti della privacy europei lanciano una task force

Dopo GPT arriva Auto-GPT

26 aprile 2023 – OpenAI annuncia la versione Business di ChatGPT

28 aprile 2023 – ChatGPT torna accessibile dall’Italia

I primi firewall per proteggere i dati

Ai primi di maggio 2023 vengono presentati Arthur Shield, un firewall per i dati di AI e NeMo Guardrails di Nvidia, che fornisce un linguaggio di policy per aiutare a proteggere gli LLM dalla perdita di dati sensibili o da risposte errate cosiddette “allucinate”. Sono i primi strumenti messi a disposizione per garantire la perdita dei dati, o data breach, con sistemi di AI generativi come ChatGPT.

18 maggio 2023 – ChatGPT sull’app store di Apple

31 maggio – ChatGPT per iPhone disponibile anche in Italia

30 maggio – Statement on AI Risk

Oltre 350 personalità del mondo hi-tech firmano una breve dichiarazi0one in cui chiedono regole per “mitigare il rischio di estinzione dell’umanità” a causa dell’intelligenza artificiale

AI e rischio estinzione per l’umanità: i big firmano un appello

14 giugno 2023 – OpenAI annuncia aggiornamenti di GPT-3.5-turbo e GPT-4 e calo dei prezzi

OpenAI: nuove chiamate delle funzioni e aggiornamenti API per GPT. Scendono i prezzi

Mercedes è la prima casa automobilistica a introdurre ChatGPT sulle proprie vetture negli Usa

Microsoft ha stretto una partnership con Mercedes: a partire dal 16 giugno, la piattaforma di intelligenza artificiale generativa è stata resa disponibile per 900mila veicoli Mercedes dotati del sistema di infotainment MBUX dell’azienda tramite un aggiornamento software.

21 agosto 2023: disponibili per gli utenti gratuiti le “istruzioni personalizzate”

Data di prima pubblicazione: 7 dicembre 2022